CentOS 6.4にOpenStack Grizzlyをインストールする手順の覚え書き

注意1

※現在、SELinuxのupdateの影響?で、grizzlyのインストールが正常に行えないので、

対処方法を投稿し直しました(記事へのリンク)

注意2

※GrizzlyのパッケージURLが変更されたため、変更箇所については

この記事にて記載した。

まずは、IP固定化

# vi /etc/sysconfig/network-scripts/ifcfg-eth0

# service network restart

そして、アップデート

# yum update -y

SELinuxをpermissiveにする

# sed -i -e "s/SELINUX=enforcing/SELINUX=permissive/g" /etc/selinux/config

再起動

# reboot

# vi /etc/sysctl.conf

------------sysctl.confの中身------------

# Controls IP packet forwarding らへんの

net.ipv4.ip_forward = 0 を下に変更

↓

net.ipv4.ip_forward=1

さらにしたを追記する↓

net.ipv4.conf.all.fowarding=1

net.ipv4.conf.all.rp_filter=0

# Do not accept source routingらへんの

net.ipv4.conf.default.rp_filter = 1 を下に変更

↓

net.ipv4.conf.default.rp_filter = 0

# Disable netfilter on bridges. らへんのやつをすべて0にする

net.bridge.bridge-nf-call-ip6tables=0

net.bridge.bridge-nf-call-iptables=0

net.bridge.bridge-nf-call-arptables=0

---------------------------------------

設定を反映

# sysctl -e -p /etc/sysctl.conf

※GrizzlyのパッケージURLが変更されたため、

# yum install -y http://rdo.fedorapeople.org/openstack/openstack-grizzly/rdo-release-grizzly-3.noarch.rpm

↓↓↓↓↓↓↓↓

変更内容はこの記事の[1]に記載した。

# yum install -y openstack-packstackまで終了したら、下の記事へのリンクの手順を踏む

↓↓↓↓↓↓↓↓

※(記事へのリンク)

ansファイルを作成する

※GrizzlyのパッケージURLが変更されたため、ansファイルに変更が必要である。詳しくはこの記事の[2]に記載した。

使用したansファイルの内容はコチラ

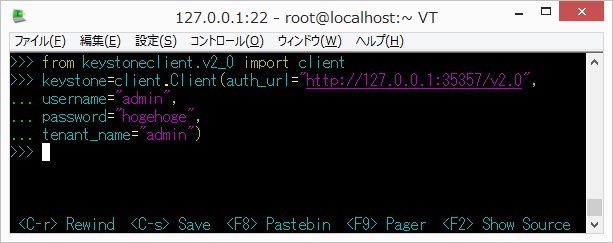

ちなみに、192.168.0.100は自分のIPアドレス で

パスワードはhogehogeにしてある

適宜、必要に応じて置き換えればいい

---------------ansの中身---------------

[general]

# Path to a Public key to install on servers. If a usable key has not

# been installed on the remote servers the user will be prompted for a

# password and this key will be installed so the password will not be

# required again

CONFIG_SSH_KEY=

# Set to 'y' if you would like Packstack to install Glance

CONFIG_GLANCE_INSTALL=y

# Set to 'y' if you would like Packstack to install Cinder

CONFIG_CINDER_INSTALL=y

# Set to 'y' if you would like Packstack to install Nova

CONFIG_NOVA_INSTALL=y

# Set to 'y' if you would like Packstack to install Quantum

CONFIG_QUANTUM_INSTALL=y

# Set to 'y' if you would like Packstack to install Horizon

CONFIG_HORIZON_INSTALL=y

# Set to 'y' if you would like Packstack to install Swift

CONFIG_SWIFT_INSTALL=n

# Set to 'y' if you would like Packstack to install the OpenStack

# Client packages. An admin "rc" file will also be installed

CONFIG_CLIENT_INSTALL=y

# Comma separated list of NTP servers. Leave plain if Packstack

# should not install ntpd on instances.

CONFIG_NTP_SERVERS=

# Set to 'y' if you would like Packstack to install Nagios to monitor

# openstack hosts

CONFIG_NAGIOS_INSTALL=n

# Comma separated list of servers to be excluded from installation in

# case you are running Packstack the second time with the same answer

# file and don't want Packstack to touch these servers. Leave plain if

# you don't need to exclude any server.

EXCLUDE_SERVERS=

# The IP address of the server on which to install MySQL

CONFIG_MYSQL_HOST=192.168.0.100

# Username for the MySQL admin user

CONFIG_MYSQL_USER=root

# Password for the MySQL admin user

CONFIG_MYSQL_PW=hogehoge

# The IP address of the server on which to install the QPID service

CONFIG_QPID_HOST=192.168.0.100

# The IP address of the server on which to install Keystone

CONFIG_KEYSTONE_HOST=192.168.0.100

# The password to use for the Keystone to access DB

CONFIG_KEYSTONE_DB_PW=hogehoge

# The token to use for the Keystone service api

CONFIG_KEYSTONE_ADMIN_TOKEN=ADMIN

# The password to use for the Keystone admin user

CONFIG_KEYSTONE_ADMIN_PW=hogehoge

# The password to use for the Keystone demo user

CONFIG_KEYSTONE_DEMO_PW=hogehoge

# Kestone token format. Use either UUID or PKI

CONFIG_KEYSTONE_TOKEN_FORMAT=UUID

# The IP address of the server on which to install Glance

CONFIG_GLANCE_HOST=192.168.0.100

# The password to use for the Glance to access DB

CONFIG_GLANCE_DB_PW=hogehoge

# The password to use for the Glance to authenticate with Keystone

CONFIG_GLANCE_KS_PW=hogehoge

# The IP address of the server on which to install Cinder

CONFIG_CINDER_HOST=192.168.0.100

# The password to use for the Cinder to access DB

CONFIG_CINDER_DB_PW=hogehoge

# The password to use for the Cinder to authenticate with Keystone

CONFIG_CINDER_KS_PW=hogehoge

# Create Cinder's volumes group. This should only be done for testing

# on a proof-of-concept installation of Cinder. This will create a

# file-backed volume group and is not suitable for production usage.

CONFIG_CINDER_VOLUMES_CREATE=y

# Cinder's volumes group size

CONFIG_CINDER_VOLUMES_SIZE=20G

# The IP address of the server on which to install the Nova API

# service

CONFIG_NOVA_API_HOST=192.168.0.100

# The IP address of the server on which to install the Nova Cert

# service

CONFIG_NOVA_CERT_HOST=192.168.0.100

# The IP address of the server on which to install the Nova VNC proxy

CONFIG_NOVA_VNCPROXY_HOST=192.168.0.100

# A comma separated list of IP addresses on which to install the Nova

# Compute services

CONFIG_NOVA_COMPUTE_HOSTS=192.168.0.100

# The IP address of the server on which to install the Nova Conductor

# service

CONFIG_NOVA_CONDUCTOR_HOST=192.168.0.100

# The password to use for the Nova to access DB

CONFIG_NOVA_DB_PW=hogehoge

# The password to use for the Nova to authenticate with Keystone

CONFIG_NOVA_KS_PW=hogehoge

# The IP address of the server on which to install the Nova Scheduler

# service

CONFIG_NOVA_SCHED_HOST=192.168.0.100

# The overcommitment ratio for virtual to physical CPUs. Set to 1.0

# to disable CPU overcommitment

CONFIG_NOVA_SCHED_CPU_ALLOC_RATIO=16.0

# The overcommitment ratio for virtual to physical RAM. Set to 1.0 to

# disable RAM overcommitment

CONFIG_NOVA_SCHED_RAM_ALLOC_RATIO=1.5

# Private interface for Flat DHCP on the Nova compute servers

CONFIG_NOVA_COMPUTE_PRIVIF=lo

# The IP address of the server on which to install the Nova Network

# service

CONFIG_NOVA_NETWORK_HOST=192.168.0.100

# Public interface on the Nova network server

CONFIG_NOVA_NETWORK_PUBIF=eth0

# Private interface for Flat DHCP on the Nova network server

CONFIG_NOVA_NETWORK_PRIVIF=lo

# IP Range for Flat DHCP

CONFIG_NOVA_NETWORK_FIXEDRANGE=10.0.0.0/24

# IP Range for Floating IP's

CONFIG_NOVA_NETWORK_FLOATRANGE=192.168.0.0/24

# Name of the default floating pool to which the specified floating

# ranges are added to

CONFIG_NOVA_NETWORK_DEFAULTFLOATINGPOOL=nova

# Automatically assign a floating IP to new instances

CONFIG_NOVA_NETWORK_AUTOASSIGNFLOATINGIP=n

# The IP addresses of the server on which to install the Quantum

# server

CONFIG_QUANTUM_SERVER_HOST=192.168.0.100

# Enable network namespaces for Quantum

CONFIG_QUANTUM_USE_NAMESPACES=y

# The password to use for Quantum to authenticate with Keystone

CONFIG_QUANTUM_KS_PW=hogehoge

# The password to use for Quantum to access DB

CONFIG_QUANTUM_DB_PW=hogehoge

# A comma separated list of IP addresses on which to install Quantum

# L3 agent

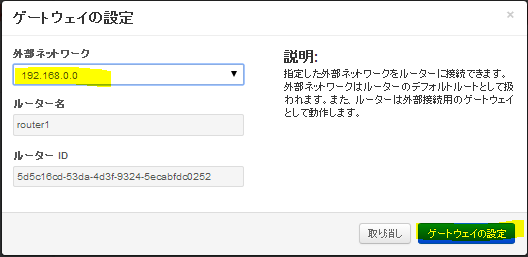

CONFIG_QUANTUM_L3_HOSTS=192.168.0.100

# The name of the bridge that the Quantum L3 agent will use for

# external traffic, or 'provider' if using provider networks

CONFIG_QUANTUM_L3_EXT_BRIDGE=br-ex

# A comma separated list of IP addresses on which to install Quantum

# DHCP agent

CONFIG_QUANTUM_DHCP_HOSTS=192.168.0.100

# The name of the L2 plugin to be used with Quantum

CONFIG_QUANTUM_L2_PLUGIN=openvswitch

# A comma separated list of IP addresses on which to install Quantum

# metadata agent

CONFIG_QUANTUM_METADATA_HOSTS=192.168.0.100

# A comma separated list of IP addresses on which to install Quantum

# metadata agent

CONFIG_QUANTUM_METADATA_PW=hogehoge

# The type of network to allocate for tenant networks

CONFIG_QUANTUM_LB_TENANT_NETWORK_TYPE=local

# A comma separated list of VLAN ranges for the Quantum linuxbridge

# plugin

CONFIG_QUANTUM_LB_VLAN_RANGES=

# A comma separated list of interface mappings for the Quantum

# linuxbridge plugin

CONFIG_QUANTUM_LB_INTERFACE_MAPPINGS=

# Type of network to allocate for tenant networks

CONFIG_QUANTUM_OVS_TENANT_NETWORK_TYPE=local

# A comma separated list of VLAN ranges for the Neutron openvswitch

# plugin

CONFIG_QUANTUM_OVS_VLAN_RANGES=physnet1:1:4000

# A comma separated list of bridge mappings for the Quantum

# openvswitch plugin

CONFIG_QUANTUM_OVS_BRIDGE_MAPPINGS=physnet1:eth0

# A comma separated list of colon-separated OVS bridge:interface

# pairs. The interface will be added to the associated bridge.

CONFIG_QUANTUM_OVS_BRIDGE_IFACES=br-ex:eth0

# A comma separated list of tunnel ranges for the Neutron openvswitch

# plugin

CONFIG_QUANTUM_OVS_TUNNEL_RANGES=1:1000

# Override the IP used for GRE tunnels on this hypervisor to the IP

# found on the specified interface (defaults to the HOST IP)

CONFIG_QUANTUM_OVS_TUNNEL_IF=

# The IP address of the server on which to install the OpenStack

# client packages. An admin "rc" file will also be installed

CONFIG_OSCLIENT_HOST=192.168.0.100

# The IP address of the server on which to install Horizon

CONFIG_HORIZON_HOST=192.168.0.100

# To set up Horizon communication over https set this to "y"

CONFIG_HORIZON_SSL=n

# PEM encoded certificate to be used for ssl on the https server,

# leave blank if one should be generated, this certificate should not

# require a passphrase

CONFIG_SSL_CERT=

# Keyfile corresponding to the certificate if one was entered

CONFIG_SSL_KEY=

# The IP address on which to install the Swift proxy service

CONFIG_SWIFT_PROXY_HOSTS=192.168.0.100

# The password to use for the Swift to authenticate with Keystone

CONFIG_SWIFT_KS_PW=f2a0f534b4de4ae6

# A comma separated list of IP addresses on which to install the

# Swift Storage services, each entry should take the format

# <ipaddress>[/dev], for example 127.0.0.1/vdb will install /dev/vdb

# on 127.0.0.1 as a swift storage device(packstack does not create the

# filesystem, you must do this first), if /dev is omitted Packstack

# will create a loopback device for a test setup

CONFIG_SWIFT_STORAGE_HOSTS=192.168.0.100

# Number of swift storage zones, this number MUST be no bigger than

# the number of storage devices configured

CONFIG_SWIFT_STORAGE_ZONES=1

# Number of swift storage replicas, this number MUST be no bigger

# than the number of storage zones configured

CONFIG_SWIFT_STORAGE_REPLICAS=1

# FileSystem type for storage nodes

CONFIG_SWIFT_STORAGE_FSTYPE=ext4

# Whether to provision for demo usage and testing

CONFIG_PROVISION_DEMO=n

# The CIDR network address for the floating IP subnet

CONFIG_PROVISION_DEMO_FLOATRANGE=172.24.4.224/28

# Whether to configure tempest for testing

CONFIG_PROVISION_TEMPEST=n

# The uri of the tempest git repository to use

CONFIG_PROVISION_TEMPEST_REPO_URI=https://github.com/openstack/tempest.git

# The revision of the tempest git repository to use

CONFIG_PROVISION_TEMPEST_REPO_REVISION=stable/grizzly

# Whether to configure the ovs external bridge in an all-in-one

# deployment

CONFIG_PROVISION_ALL_IN_ONE_OVS_BRIDGE=n

# To subscribe each server to EPEL enter "y"

CONFIG_USE_EPEL=y

# A comma separated list of URLs to any additional yum repositories

# to install

CONFIG_REPO=http://repos.fedorapeople.org/repos/openstack/openstack-grizzly/epel-6/

# The IP address of the server on which to install the Nagios server

CONFIG_NAGIOS_HOST=192.168.0.100

# The password of the nagiosadmin user on the Nagios server

CONFIG_NAGIOS_PW=hogehoge

---------------------------------------

#packstack --answer-file=ans.txt

しばらく、待つことになるので待機

次回に続く